BTC/HKD+5.82%

BTC/HKD+5.82% ETH/HKD+7.41%

ETH/HKD+7.41% LTC/HKD+4.07%

LTC/HKD+4.07% ADA/HKD+9.54%

ADA/HKD+9.54% SOL/HKD+7.67%

SOL/HKD+7.67% XRP/HKD+9.48%

XRP/HKD+9.48%來源:新智元編輯:Aeneas好困

快速定制模型的LLM引擎Lamini來了,開發者狂喜!

ChatGPT雖好,但始終有門檻。通常,只有擁有AI博士學位的大型機器學習團隊,才能這樣訓練一個模型。

為了把這個門檻打下來,團隊構建了Lamini引擎,從此,每個開發者都能夠擁有從GPT-3訓練ChatGPT的超能力!

劃重點:可以商用!可以商用!可以商用!

項目地址:https://github.com/lamini-ai/lamini/

Lamini的開發團隊表示,你需要的只是幾行代碼,就可以用托管數據生成器倆訓練自己的LLM,包括權重和其他所有的內容。

此外,你也可以使用開源的LLM,用Lamini庫對生成的數據進行微調。以及訪問完整的LLM訓練模塊,使用從LoRa等速度優化,到虛擬私有云(VPC)部署等企業功能。

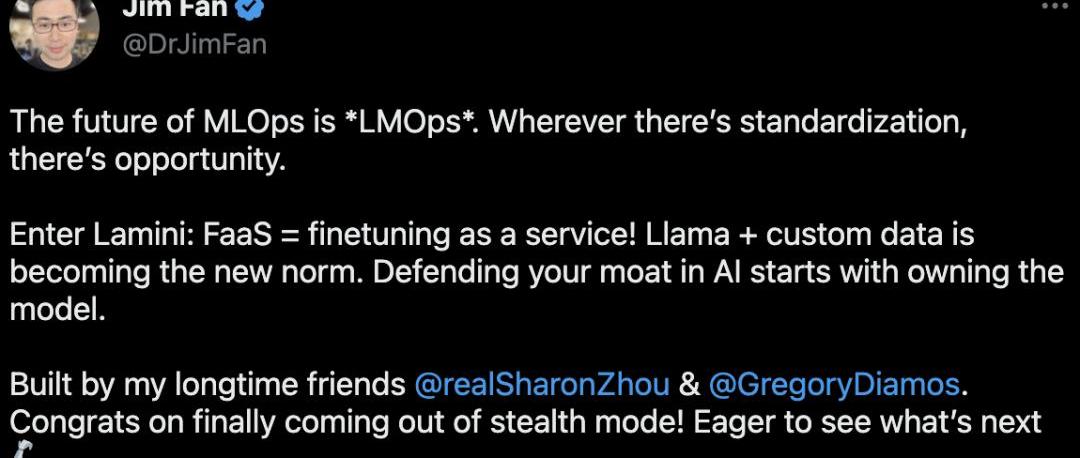

對此,英偉達科學家JimFan表示,LLaMa+自定義數據正在成為新的范式,而Lamini的推出也帶了一種全新的模式——FaaS,微調即服務。

JPEG'd:JPEG'd合約未被黑客攻擊,NFT與財庫資金安全:7月31日消息,DeFi公共產品JPEG'd發推稱,pETH-ETH曲線池遭遇攻擊。允許借用NFT的金庫合約是安全的,仍在正常運行。NFT與財庫資金安全。JPEG'd合約沒有被黑客攻擊,是安全的。

金色財經此前報道,據Beosin旗下Beosin EagleEye安全風險監控、預警與阻斷平臺監測顯示,JPEG'd遭遇攻擊,損失至少約1000萬美元。JPEG'd遭遇攻擊的根本原因在于重入,攻擊者在調用remove_liquidity函數移除流動性時通過重入add_liquidity函數添加流動性,由于余額更新在重入進add_liquidity 函數之前,導致價格計算出現錯誤。[2023/7/31 16:08:05]

MLOps的未來是「LMOps」。哪里有標準化,哪里就有機會。

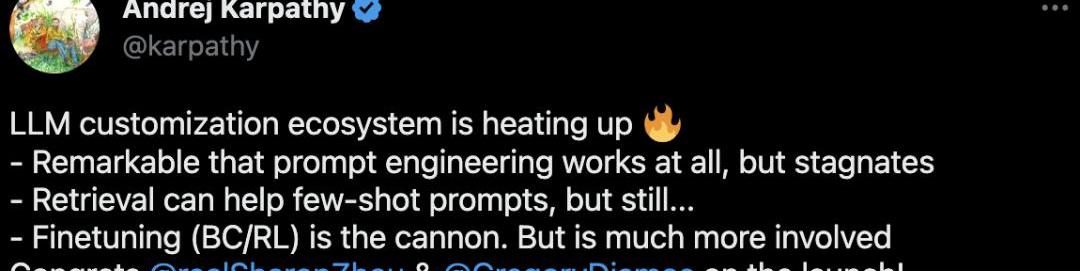

OpenAI科學家,前特斯拉人工智能總監AndrejKarpathy也表示,LLM定制化的生態正在愈發火爆。

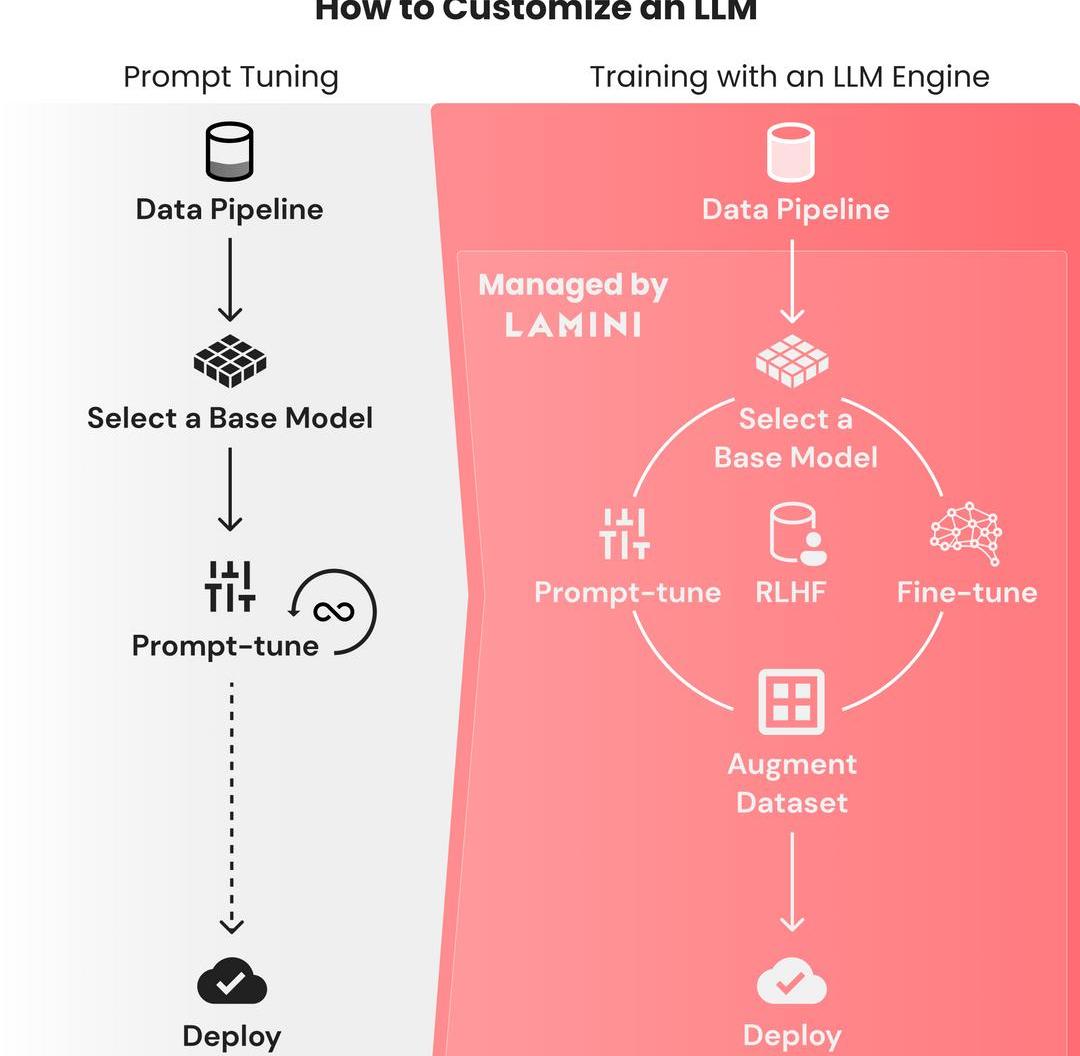

訓LLM就像prompt-tuning一樣簡單

寫一個prompt如此容易,但想要從基礎模型訓練出一個大語言模型,卻是如此困難。

因為需要花費大量時間,來找出微調模型失敗的原因,所以對數據集微調的迭代周期都是以月為單位的。

與之相反,微調prompt的迭代,只需要幾秒鐘,并且在幾個小時內,性能都能保持穩定。

這個過程只需要把有限數量的數據整合到prompt中就可以了,并不需要動輒幾TB的數據。

過去一周主流Layer2中僅dYdX TVL實現增長,增幅為1.11%:7月8日消息,L2BEAT數據顯示,目前以太坊Layer2總鎖倉量為95.2億美元,7日降幅為2.83%。

其中鎖倉量前五分別為:Arbitrum One(鎖倉量57.2億美元,7日降幅2.72%)、Optimism(鎖倉量21.4億美元,7日降幅4.14%)、zkSync Era(鎖倉量6.81億美元,7日漲幅2.16%)、dYdX(鎖倉量3.48億美元,7日增幅1.11%)、Immutable X(鎖倉量9747萬美元,7日降幅3.52%)。[2023/7/8 22:25:33]

ChatGPT的誕生十分艱難,OpenAI的團隊花了幾個月的時間,在基礎的GPT-3模型上微調,并進行RLHF。這個門檻極高,只有大型的ML團隊才能完成這種訓練。

有500強企業的技術負責人這樣抱怨過:「我們團隊的10名機器學習工程師用了OpenAI的微調API,結果我們的模型反而變得更差了,怎么辦啊。」

「我真的不知道該怎么充分利用數據,我已經用盡了所有從在線教程中能學到的prompt魔法了。」

這,就是研究者構建Lamini的原因:讓每個開發者可以直接從GPT-3訓練ChatGPT。

任意LLM,秒變ChatGPT!

Lamini是一個LLM引擎,可以讓不僅僅是機器學習專家的任何開發人員,都能在大型數據集中,把高性能的LLM訓練得像ChatGPT一樣好。

Metatime已完成2500萬美元融資:金色財經報道,加密貨幣交易所Metatime已完成2500萬美元融資,并準備在全球交易所上市其生態系統代幣。此外,Metatime并推出自己的區塊鏈網絡MetaChain。[2023/6/24 21:56:51]

這個過程,只需要Laimini庫的幾行代碼即可。

值得注意的是,這個庫中的優化遠遠超出了現在開發者可以使用的范圍,從更具挑戰性的優化到更簡單的優化。

比如,你想從不同的角度生成一個廣告文案。

首先,從llama模塊導入LLM引擎:

fromllamaimportLLMllm=LLM(name="marketing")

接下來,需要定義輸入和輸出類型。注意,這里一定要包括上下文,因為可以有助于LLM在自然語言中進行理解。

fromllamaimportType,ContextclassAdAspects(Type):tone:str=Context("toneofthemarketingcopy")product_features:list=Context("productfeaturestopromote")audience:str=Context("targetaudienceforthemessage")subject:str=Context("subjectortopicofthemessage")goal:str=Context("goalofthismarketingcampaignandmessage")classAdCopy(Type):title:str=Context("googleadtitletag")description:str=Context("googleaddescription")keywords:list=Context("keywordsforthesearchengine")

Blur更新投標積分機制:轉移NFT以獲取忠誠度:6月8日消息,NFT市場Blur已更新投標積分(Bidding Points)機制,其中轉移NFT以獲得忠誠度、對敲交易、虛假出價行為將不再獲得BLUR獎勵。

其中忠誠度對Season 2至關重要,將NFT轉移到其他市場上會降低忠誠度,這不會反映在UI中,但轉移到其他市場的交易會在后端被追蹤,從而降低轉移者的忠誠度。此外,對敲交易、虛假出價將從Season 2開始被過濾掉。

頂級系列仍然獲得最多的積分,但積分也已經更新,以便在系列之間更均勻地分配。[2023/6/8 21:23:31]

然后就可以開始提問了:

語氣:大膽,但不傲慢

特色:亞洲醬料和香料、家常調料和套餐包,可以輕松在家烹飪。

aspects=AdAspects(tone="boldandbright,butnotarrogant",product_features=,audience="suburbanfamilies",subject="deliciousasianmealswithoutgoingtoarestaurant",goal="getsuburbanmomsanddadstotrybuytheirfirstomsompackorfreetastingkit")ad_copy=llm(input=aspects,output_type=AdCopy)print(f"Adcopy:{ad_copy}")模型輸出:

嘗試Omsom的美味亞洲醬料、香料、家常調料和套餐包。輕松為家人在家做出美味佳肴。

>title='DeliciousAsianMealsWithoutGoingtoaRestaurant|Omsom'description="TryOmsom'sdeliciousAsiansauces,aromatics,andhome-cookedseasoningsandmealpacks.Easilycookdeliciousmealsathomeforyourfamily."keywords=

Ledger新增支持Trust Wallet瀏覽器插件:2月28日消息,硬件錢包 Ledger 新增支持多鏈自托管錢包 Trust Wallet 瀏覽器插件。通過本次合作,Trust wallet 用戶將可以通過硬件解決方案為賬戶增加一層安全保護,Ledger 用戶也可以快速靈活訪問鏈上 DApp 和一鍵式管理多錢包資產,同時實現線上線下錢包的輕松切換。[2023/2/28 12:34:38]

如何創建自己的「ChatGPT」

基礎模型能理解一般的英語,但如果需要它們學習一些垂直語言和規則,prompt微調并不足夠,很多時候我們都需要構建自己的LLM。

利用用下面這個步驟,就能獲得像ChatGPT一樣遵循指令的LLM。

嘗試prompt-tuningChatGPT或其他模型

可以使用Lamini庫的API,在不同模型之間快速進行prompt-tuning,只需一行代碼,即可在OpenAI和開源模型之間切換。

Lamini庫已經優化了正確的prompt,這樣開發者就可以使用不同的模型,不必擔心如何為每個模型設置prompt的格式。

構建一個包含輸入-輸出對的大型數據集

這些數據集會向模型展示,它應該如何響應輸入,無論是遵循英文說明,還是以JSON響應。

研究者剛剛發布了一個只有幾行代碼的repo,使用Lamini庫,僅從100個數據點中,就能生成50k數據點。

而且因為使用Lamini庫來啟動Lamini引擎,所以這個過程根本不需要用到GPU。

在repo中,已經包含一個開源的70+k數據集。

項目地址:https://github.com/lamini-ai/lamini/

在大型數據集上微調基礎模型

除了數據生成器,研究者還發布了一個LLM,它使用Lamini對生成的數據進行了微調。以編程方式執行此操作的功能也會很快發布。

也可以把OpenAI的微調API作為起步。

在微調模型上進行RLHF

使用Lamini,就不再需要大型ML和人工標記團隊來運行RLHF。

部署到云端

只需點擊產品或功能中的API端點即可。

專為LLM打造的數據生成器

簡單來說,依照以下幾個步驟,就可以訓練自己的大語言模型了。

用于優化prompt微調和類型化輸出的Lamini庫。

用于微調和RLHF的高級Lamini庫,只需幾行代碼。

史上首個托管數據生成器,用于創建數據,來訓練遵循指令的LLM。注意,已獲得商業使用許可!

開源的指令跟隨LLM,使用上述工具,只需幾行代碼即可完成。

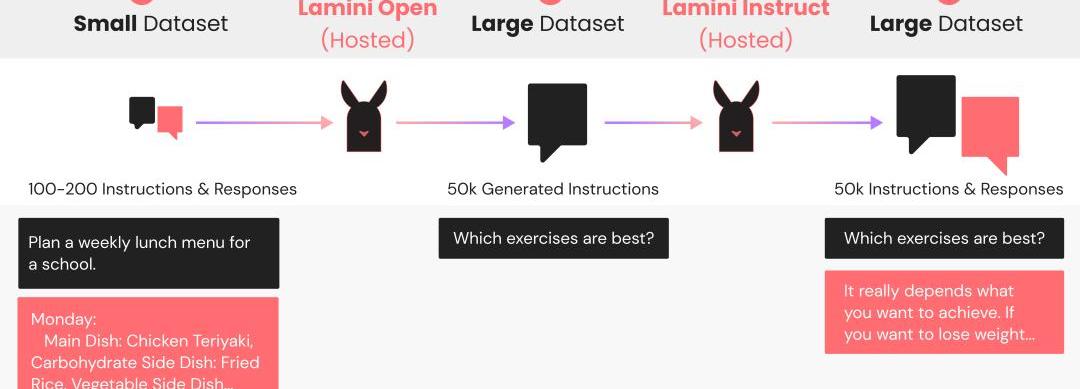

數據生成器工作原理

Lamini數據生成器是一個LLM管線,它采用原始的100多條指令的小集合,與預期的響應配對,生成50k+新的配對,靈感來自Stanford的Alpaca。這個生成管線使用Lamini庫來定義和調用LLM,以生成不同但相似的指令和響應對。

根據這些數據訓練后,你的LLM會遵循這些指示,因而得到改進。對于使用開源LLM的生成管線,研究者提供了一個很好的默認值,LaminiOpen和LaminiInstruct。

隨著每天新的LLM發布,研究者都會將默認值更新為性能最佳的模型。在目前的版本中,LaminiOpen用的是EleutherAI的Pythia,LaminiInstruct用的是Databricks的Dolly。

LaminiOpen會生成更多指令,而LaminiInstruct會生成這些指令的成對響應。

最終生成的數據集可供免費商業使用,已經通過CC-BY許可。

僅用一行代碼,就可以將Lamini庫的默認值換成其他開源或OpenAI模型。

研究者發現,OpenAI模型的平均表現更好,但它們的許可限制了將生成數據用于訓練類ChatGPT模型的商用。

對生成數據進行微調

在這個過程中,生成的數據會質量不一。

在微調之前,下一步就是將生成的數據過濾為高質量數據。

然后,Lamini會通過在這個過濾后生成的數據集上訓練基礎模型,來創建自定義LLM。

研究者已經發布了一個開源指令跟隨LLM,可以用Lamini來訓練Pythia基礎模型,生成的37k指令是從70k中篩選出來的。

顯然,Lamini庫的出現,讓迭代周期變得更快、更有效,有更多的人能夠構建模型,而不僅僅是試驗各種prompt。

團隊介紹

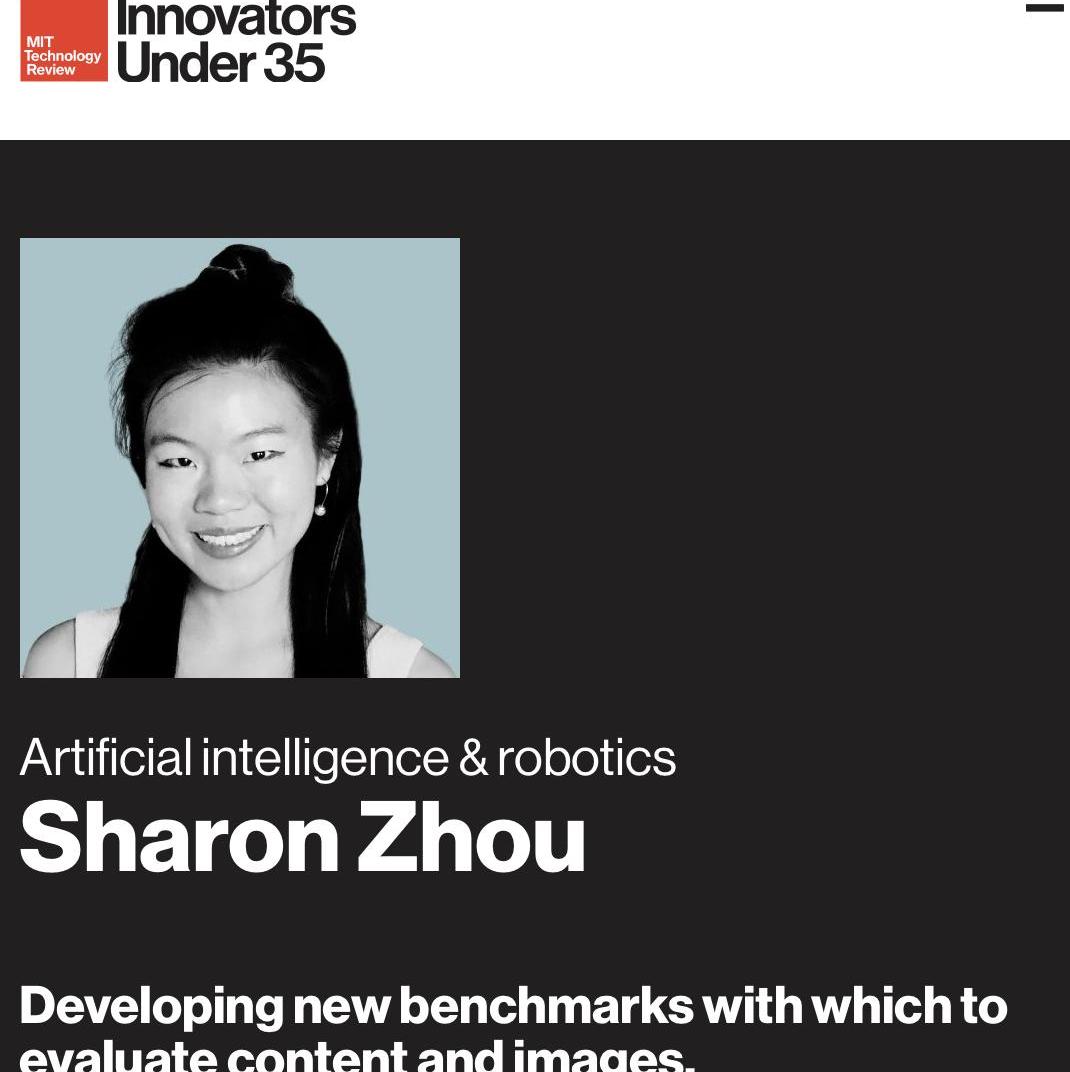

SharonZhou是Lamini的聯合創始人兼首席執行官。

個人主頁:https://sharonzhou.me/

她在哈佛大學獲得了計算機科學與古典文學聯合學士學位,并以最高榮譽獲得了碩士學位。

隨后,她在斯坦福大學獲得了計算機科學博士學位,師從吳恩達。

2022年,29歲的Zhou入選《麻省理工科技評論》「35歲以下科技創新35人」。

GregoryDiamos是MLPerf的聯合創始人。

他曾是百度硅谷AI實驗室的創始成員,對DeepSpeech和DeepVoice系統有貢獻。

參考資料:

https://lamini.ai/blog/introducing-lamini

Tags:MINIMINPROROMMINIFOOTBALLGAMINGSHIBAProplandCryptochrome

來源:澎湃新聞 作者:智造前研導語 2022年11月30日,美國OpenAI發布聊天機器人ChatGPT,上線2個月月活用戶過億,刷新了互聯網應用用戶增長記錄.

1900/1/1 0:00:00來源:深瞳商業,作者:河馬君、楚青舟眾所周知,小紅書已經籌備“大模型”團隊。據36氪5月6日消息,小紅書自3月起開始籌備建立獨立的大模型團隊,核心員工來自廣告業務的NLP技術團隊.

1900/1/1 0:00:00除了大火的?BRC-20?以外,比特幣現在還有包括?BRC-21、ORC-20等諸多創新,或許都可潛在的下一個熱點.

1900/1/1 0:00:00作者:chengshutong一、初聞Ordinals、BTC-NFT、BRC-20這部分是概念的堆砌,雖然可以幾句話講明白,但是還是想從原理的角度,將每一個知識點穿起來.

1900/1/1 0:00:00Layer3和應用鏈解決方案的崛起為以太坊生態系統帶來了新的可能性。在這篇文章中,Scroll研究員Yicheng將深入探討L3的主要優勢和Scroll的發展,以及個人期待的未來探索方向.

1900/1/1 0:00:00原創:顏艷春 來源:筆記俠 原文標題:《掙大錢,靠周期》內容來源:2023年4月25日,盛景大咖談.

1900/1/1 0:00:00