BTC/HKD-0.54%

BTC/HKD-0.54% ETH/HKD-2.12%

ETH/HKD-2.12% LTC/HKD-2.51%

LTC/HKD-2.51% ADA/HKD-0.84%

ADA/HKD-0.84% SOL/HKD-2.02%

SOL/HKD-2.02% XRP/HKD-2.84%

XRP/HKD-2.84%

作者|劉大一恒、齊煒禎、晏宇、宮葉云、段楠、周明

編者按:微軟亞洲研究院提出新的預訓練模型ProphetNet,提出了一種新的自監督學習目標——同時預測多個未來字符,在序列到序列的多個自然語言生成任務都取得了優異性能。

大規模預訓練語言模型在自然語言理解和自然語言生成中都取得了突破性成果。這些模型通常使用特殊的自監督學習目標先在大規模無標記語料中進行預訓練,然后在下游任務上微調。

傳統自回歸語言模型通過估計文本語料概率分布被廣泛用于文本建模,序列到序列的建模,以及預訓練語言模型中。這類模型通常使用teacher-forcing的方法訓練,即每一時刻通過給定之前時刻的所有字符以預測下一個時刻的字符。然而,這種方式可能會讓模型偏向于依賴最近的字符,而非通過捕捉長依賴的信息去預測下一個字符。有如以下原因:局部的關系,如兩元字符的組合,往往比長依賴更強烈;Teacher-forcing每一時刻只考慮對下一個字符的預測,并未顯式地讓模型學習對其他未來字符的建模和規劃。最終可能導致模型對局部字符組合的學習過擬合,而對全局的一致性和長依賴欠擬合。尤其是當模型通過貪心解碼的方式生成序列時,序列往往傾向于維持局部的一致性而忽略有意義的全局結構。

以太坊Layer2總鎖倉量近100億美元,7日漲幅2.03%:金色財經報道,據L2BEAT數據顯示,以太坊Layer2總鎖倉量為99.7億美元,7日漲幅2.03%。鎖倉量前五分別為:Arbitrum One(59.8億美元,7日漲幅0.52%);OP Mainnet(22.6億美元,7日漲幅2.72%);zkSync Era(7.37億美元,7日漲幅16.43%);dYdX(3.45億美元,7日跌幅1.46%);Immutable X(1.03億美元,7日漲幅1.91%)。[2023/7/4 22:17:26]

ProphetNet

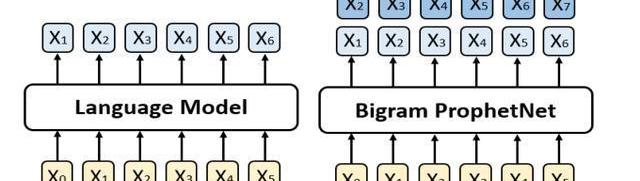

針對上述問題,我們提出了一個新的seq2seq預訓練模型,我們稱之為ProphetNet。該模型帶有一個新穎的自監督學習目標函數,即預測未來的N元組。與傳統seq2seq的Teacher-forcing每一時刻只預測下一個字符不同,ProphetNet每一時刻將學習去同時預測未來的N個字符。如圖1所示:

Michael Saylor:比特幣現貨ETF將成為機構接受比特幣的里程碑:6月30日消息,MicroStrategy聯合創始人兼執行主席 Michael Saylor 在接受 The Block 采訪時表示,比特幣現貨 ETF 將是加密行業的一大發展,并成為機構接受比特幣的里程碑,但這不一定會導致比特幣價格短期大幅上漲。[2023/7/1 22:11:28]

圖1:左邊是傳統的語言模型,每一時刻預測下一時刻的字符。右邊是Bigram形式下的ProphetNet,每一時刻同時預測未來的兩個字符。

預測未來N元組這一自監督學習目標在訓練過程中顯式地鼓勵模型在預測下一個字符時考慮未來更遠的字符,做到對未來字符的規劃,以防止模型對強局部相關過擬合。

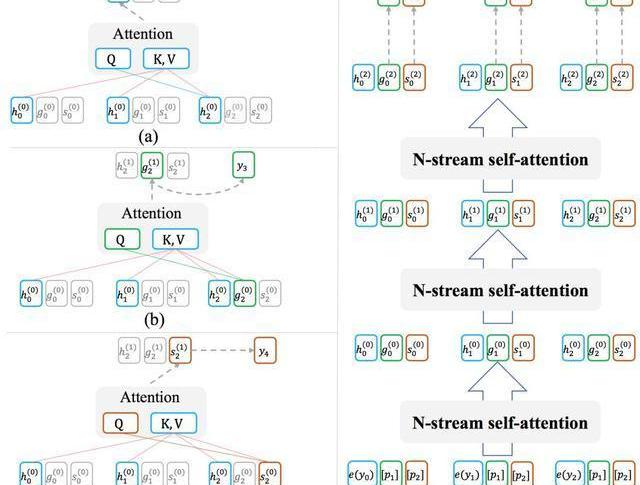

ProphetNet基于Transformer的seq2seq架構,其設計有兩個目標:1.模型能夠以高效的方式在訓練過程中完成每時刻同時預測未來的N個字符;2.模型可以靈活地轉換為傳統的seq2seq架構,以在推理或微調階段兼容現有的方法和任務。為此,我們受XLNet中Two-streamselfattention的啟發,提出了用于模型decoder端的N-streamself-attention機制。圖2展示了bigram形式下的N-streamself-attention樣例。

FTX破產管理地址接收數筆從Alameda相關錢包轉入的ARBToken,約合4.2萬美元:金色財經報道,鏈上數據顯示,由 FTX 破產財產控制的錢包已經從與 Alameda Research 相關的錢包中收到了幾筆 Arbitrum (ARB) 空投,該錢包現在擁有 33,125 枚 ARB 代幣,價值約為 42,000 美元。

該錢包還持有價值 1000 萬枚 USDC、近 300 萬美元的 WBTC 和 400 萬美元的 ETH。[2023/3/27 13:29:03]

除了原始的multi-headself-attention之外,N-streamself-attention包含了額外的N個predictingstreamself-attention,用于分別預測第n個未來時刻的字符所示。每一個predictingstream與mainstream共享參數,我們可以隨時關閉predictingstream以讓模型轉換回傳統seq2seq的模式。

Optimism生態NFT市場Quix宣布代碼庫開源:金色財經報道,Optimism生態NFT市場Quix在社交媒體宣布代碼庫開源,涉及NFT交易平臺、NFT索引器和Launchpad的前端和后端代碼,現在任何開發者都可以進行部署和拓展。Quix于去年11月稱每月基礎設施成本已超過收入因此計劃在2023年2月終止運營,并結束了交易激勵機制,Quix將與Optimism基金會合作,以確保平穩過渡,其團隊致力于維持運營到2023年2月28日。[2023/2/18 12:14:51]

圖2:(a)為mainstreamself-attention;(b)為1-stpredictingstreamself-attention;(c)為2-ndpredictingstreamself-attention;(d)展示了n-streamself-attention的輸入輸出及流程。

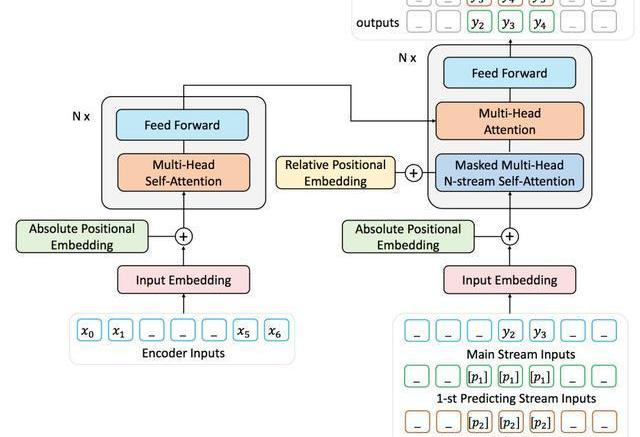

由于難以獲取到大量帶標記的序列對數據,我們用去噪的自編碼任務通過大量無標記文本預訓練ProphetNet。去噪的自編碼任務旨在輸入被噪音函數破壞后的序列,讓模型學習去復原原始序列。該任務被廣泛應于seq2seq模型的預訓練中,如MASS、BART、T5等。本文中使用MASS的預訓練方式,通過引入提出的predictingn-stream自監督學習目標函數預訓練ProphetNet。我們以bigram形式的ProphetNet為例,整個流程如圖3所示:

Cartan Group發起提案要求將ApeCoin DAO合同延長12個月,目前反對票超67%:12月18日消息,Cartan Group已發起新提案AIP-183,要求ApeCoin DAO社區將雙方合同延長12個月,并將ApeCoin DAO每月分配給其的資金從15萬美元增加到25萬美元和2萬枚APE。Cartan Group是ApeCoin DAO成立之初的社區“管理員”,負責對社區提案的治理流程和投票流程進行管理,本次投票將于12月22日結束,目前反對票達到67.24%,如果ApeCoin DAO社區不通過提案AIP-183,那么Cartan Group在2023年將無法成為社區管理員,后續可能會找一個替代者管理各種任務,包括取代其ApeCoin基金會董事角色。[2022/12/18 21:52:22]

圖3:二元形式下的Prophet整體框架圖

實驗結果

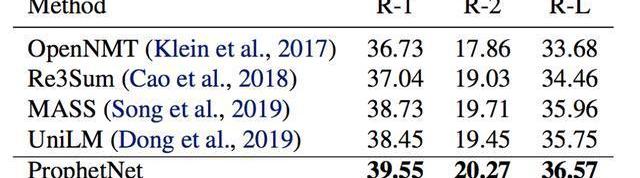

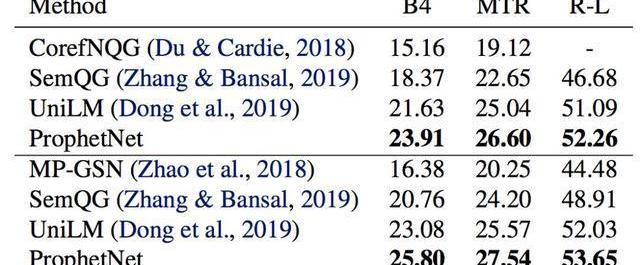

我們使用兩個規模的語料數據訓練ProphetNet。ProphetNet包含12層的encoder和12層的decoder,隱層大小為1024。先在BERT所使用的BookCorpus+Wikipedia的數據上預訓練模型,將模型在Textsummarization和Questiongeneration兩個NLG任務上的三個數據集微調并評估模型性能。與使用同等規模數據的預訓練模型相比,ProphetNet在CNN/DailyMail、Gigaword和SQuAD1.1questiongeneration數據集上都取得了最高的性能,如表1-3所示。

表1:CNN/DailyMail測試集結果

表2:Gigaword測試集結果

表3:SQuAD1.1測試集結果SQuAD1.1交換驗證測試集結果

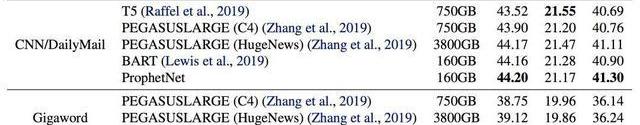

除了使用16GB的語料訓練模型,我們也進行了更大規模的預訓練實驗。該實驗中,我們使用了160GB的語料預訓練ProphetNet。我們展示了預訓練14個epoch后的ProphetNet在CNN/DailyMail和Gigaword兩個任務上微調和測試的結果。如表4所示。需要注意的是,在相同大小的訓練數據下,我們模型的預訓練epoch僅約為BART的三分之一。我們模型的訓練數據使用量僅約為T5和PEGASUSLARGE的五分之一,約為PEGASUSLARGE的二十分之一。盡管如此,我們的模型仍然在CNN/DailyMail上取得了最高的ROUGE-1和ROUGE-LF1scores。并在Gigaword上實現了新的state-of-the-art性能。

表4:模型經大規模語料預訓練后在CNN/DailyMail和Gigaword測試集的結果

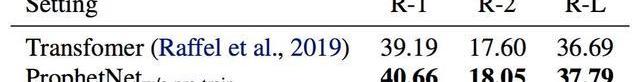

為了進一步探索ProphetNet的性能,我們在不預訓練的情況下比較了ProphetNet和Transformer在CNN/DailyMail上的性能。實驗結果如表5所示,ProphetNet在該任務上超越了同等參數量的Transformer。

表5:模型不經過預訓練在CNN/DailyMail驗證集結果

總結

本文介紹了微軟亞洲研究院在序列到序列模型預訓練的一個工作:ProphetNet,該模型提出了一種新的自監督學習目標,在同一時刻同時預測多個未來字符。并通過提出的N-streamself-attention機制高效地實現了模型在該目標下的訓練。實驗表明,該模型在序列到序列的多個自然語言生成任務都取得了不錯的性能。我們將在之后嘗試使用更大規模的模型架構和語料進行預訓練,并進一步深入地探索該機制。

論文鏈接:https://arxiv.org/pdf/2001.04063.pdf

原力計劃

《原力計劃-學習力挑戰》正式開始!即日起至3月21日,千萬流量支持原創作者!更有專屬等你來挑戰

Python數據清理終極指南口罩檢測識別率驚人,這個Python項目開源了談論新型冠狀病、比特幣、蘋果公司……沃倫巴菲特受訪中的18個金句,值得一看!天貓超市回應大數據殺熟;華為MateXs被熱炒至6萬元;Elasticsearch7.6.1發布一張圖對比阿里、騰訊復工的區別不看就虧系列!這里有完整的Hadoop集群搭建教程,和最易懂的Hadoop概念!|附代碼

作者:VV一笑ヽ 如果有一個p2p的demo,我們要怎么才能應用到區塊鏈當中?今天就來一起嘗試一下吧!首先,我們需要模擬網絡中的多個節點相互通訊.

1900/1/1 0:00:00來自緬甸的一個壯觀的新琥珀化石擁有迄今為止發現的最小的史前恐龍的頭骨:一種生活在9900萬年前的類鳥生物,并不比今天活著的最小的鳥大.

1900/1/1 0:00:00來源:東方財富網 原標題:昔日千億巨頭閱文集團再異動!股價兩日暴漲20%,只因騰訊一個動作 昨日下午3點50分到4點,港股收盤的最后10分鐘,閱文集團股價異動,大漲近6%.

1900/1/1 0:00:00今天一早,在低位徘徊了好久的比特幣,突然就沖破了8000+美元,小鹿估摸著又有什么大事件發生了吧,果然早間新聞一點開,伊朗炮轟美軍基地!其實隨著美伊關系的緊張,這段時間比特幣的價格相當的有沖勁.

1900/1/1 0:00:00大家好!爐石傳說新版本外域的灰燼給除了惡魔獵手外的九大職業都推出了一張終極隨從。兩個周的時間過去了,兩個平衡補丁上線,三次天梯環境變化,這九張終極隨從到底表現如何,是否當得起“終極”這個名號呢?.

1900/1/1 0:00:00加密貨幣挖礦現在有利可圖嗎?是和否。這取決于您開采的方式和方式,再加上電費,具體取決于鉆機或農場的所在地.

1900/1/1 0:00:00