BTC/HKD+5.95%

BTC/HKD+5.95% ETH/HKD+8.83%

ETH/HKD+8.83% LTC/HKD+4.42%

LTC/HKD+4.42% ADA/HKD+8.09%

ADA/HKD+8.09% SOL/HKD+8.57%

SOL/HKD+8.57% XRP/HKD+9.6%

XRP/HKD+9.6%1、有人說,ChatGPT是個文科生。

這么說,只因為ChatGPT是一種大型語言模型,基于自然語言處理技術,通過深度學習模型對大量文本數據進行訓練,從而學習到語言的規律和語義表達。

2、有人說,ChatGPT是個理科生。

自然語言處理本質上仍然是計算機語言。其發展的第二階段是基于統計的機器學習,第三階段是基于神經網絡的深度學習,和人類的語言學規則關系不大。

3、還有人說,ChatGPT是個體育生。

創造了阿爾法狗的哈薩比斯認為,ChatGPT僅僅是更多的計算能力和數據的蠻力,并對這種“不優雅”的方式感到失望。

本文將從一道經典的“兩孩難題”開始,引出ChatGPT背后的概率思維,以及19世紀以來人類面臨的不確定性困境。

自亞里士多德與柏拉圖之間的辯論開始,到休謨和貝葉斯二人隔著歷史的相殺相愛,再到不愿意相信上帝是在扔骰子的因果哲學堅守者愛因斯坦,人類在哲學和科學范疇里糾結于確定性與不確定性,并且越陷越深。

我偏向于用一種介于“樂觀”和“懷疑”之間的態度來評判ChatGPT引發的又一輪AI熱潮。

本文將用一種個人化的方式,從零基礎數學計算的源頭,再推演一遍貝葉斯公式,和概率推理的機制,以及神經網絡的基本原理。

進而,經過了簡單但卻可感知的數學計算,我們就可以順著休謨的經驗主義和懷疑論,一路奔襲到羅素的邏輯原子主義,直至維特根斯坦的立場:

語言的界限,就是世界的界限。

人工智能的變遷,幾乎對應著人類認知世界的變遷結構。

從確定性到不確定性,從物理定律到統計概率,物理和信息交匯于“熵”,并以類似的達爾文觀念,進化出有生命的熵減系統。???

在這個愈發茫然的世界里,AI在疫情后時代獲得了世人額外的關切;

諸神已被人類背棄,算法用強大而未知的相關性替代了神秘主義和因果霸權,仿佛成為新神。

真實與信念,確定與隨機,意識與虛無,再次于大眾的狂歡之中,對峙在時代的斷崖邊緣。

我們來看99%的聰明人都搞錯了的問題。

問題:一個家庭里有兩個孩子,其中一個是男孩,假設每個孩子是男孩女孩的概率一樣,那么另一個孩子也是男孩的概率是多少?

直覺上,生男生女絕大多數時候是獨立事件,其中一個是男孩,并不會影響另外一個孩子性別的概率,所以答案難道不是50%嗎?

有些頂尖聰明人說:不對。正確的答案應該是1/3。

用古典概率的計算方法如下:

兩個孩子的性別共有4種情況:

(男,男)、(女,女)、(男,女)、(女,男)

請注意,上述第三種和第四種情況,特別強調了老大和老二的區別。

如上四種情況中,其中一個是男孩共有3種情況:

(男,男)、(男,女)、(女,男)

另一個也是男孩只有1種情況:(男,男),所以概率是1/3。

麻煩來了:這是不是說,一個家庭假如有了一個男孩,再生一個男孩的概率就變成1/3了???

這不科學啊。????

聰明如你,應當能從這看似嚴謹但其實含混的表述中發現秘密:

上面的計算,考慮了“有一個男孩家庭”里男孩是老大或老二的兩種可能,但是卻忽略了問題里“一個男孩”在“兩個孩子都是男孩的家庭”里也有老大和老二兩種可能。??????

所以,僅就本文開頭題目的表述而言,答案仍然應該是1/2。?

讓我們在這個經典的“兩孩難題”上再前進一步。????

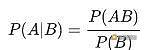

堅持認為正確答案是1/3的聰明人,會拿出貝葉斯公式。???

他們認為,本文開頭的題目,不是古典概率問題,而是條件概率問題。

所謂“條件概率”,是指:事件A在另外一個事件B已經發生條件下的發生概率。

條件概率表示為:P(A|B),讀作“在B條件下A的概率”。

根據該公式,計算如下:

條件B:兩個孩子其中一個是男孩。

考慮其對立事件:兩個孩子都不是男孩,或者說兩個孩子都是女孩。

P(B)=1-(1/2)×(1/2)=1-1/4=3/4

事件A:另一個也是男孩。

事件A、B同時發生:兩個孩子都是男孩

P(AB)=(1/2)×(1/2)=1/4

P(A|B)=P(AB)/P(B)=(1/4)/(3/4)=1/3

所以,P(A|B)=1/3。

慢著,這是語言游戲嗎?

答案到底是1/2,還是1/3??????

難道貝葉斯公式也錯了嗎??

這一節的計算是“對”的,但根據該計算得出的結論應該是:????

你觀察到的這個男孩,來自兩孩家庭的概率是1/3。???

BNB Beacon Chain預計將在4月21日進行預定的硬分叉升級:金色財經報道,BNB Beacon Chain預計將在區塊高度310182000處進行預定的硬分叉升級。根據當前的區塊生成速度,預計硬分叉將于2023年4月21日7:00(UTC)發生。主網上的全節點運行者必須在4月21日之前將其軟件版本切換至v0.10.10。[2023/4/14 14:04:45]

我不止一次地看到,即使是很聰明的人,以及專業人士,都在如上這一問題上繞不出來。

為什么呢?

因為語言的世界,不同語言的世界,個體觀察的世界,不同個體觀察的世界,以及上帝視野的世界,和所謂“真實“的世界,似乎都不是同一個世界。???

在微軟的報告里,研究者用GPT-4模擬了一段對話:

蘇格拉底:我的朋友,我對最近這些所謂自回歸語言模型的興起感到不安。

亞里士多德:你是什么意思,蘇格拉底?

蘇格拉底:我的意思是,這些模型被用來生成看起來是人類寫的文本,但實際上是由機器產生的。

亞里士多德:那有什么問題呢?

蘇格拉底:問題是,這些模型被用來欺騙人們,操縱他們,控制他們。

亞里士多德:但這些模式肯定也有一些積極的應用?

蘇格拉底:可能是這樣,但我仍然對濫用的可能性感到不安。畢竟,一個能夠生成與人類所寫的文字無法區分的模型可以被用來傳播假新聞,冒充他人,并制造宣傳。

亞里士多德:但這不只是一個如何使用這些模型的問題,而不是模型本身的問題嗎?

蘇格拉底:我不同意。我認為這些模型本身就有問題。它們是一種偽裝的形式,一種創造幻覺的方式,是人類思想和互動的一部分。因此,它們可以被用來以難以察覺的方式進行欺騙和操縱。

亞里士多德:但這不正是你反對修辭和演說的理由嗎?

蘇格拉底:是的,我也堅持這個觀點。我相信,任何旨在欺騙或操縱的藝術或交流形式都是內在的危險。

亞里士多德:我明白了。謝謝你分享你的想法,蘇格拉底。

喬布斯曾經設想過如上的對話,他預測有一天可以用計算機捕捉亞里士多德的底層世界觀,如此一來人們就可以和他親自對話了。

反對修辭和演說的蘇格拉底認為:感覺是不可靠的,感性認識是不確定的,只有理性才能夠認識事物本身。??

而在亞里士多德的方法里,他將修辭確定為哲學的三個關鍵要素之一。另外兩個則是邏輯和辯證法。

亞里士多德認為,邏輯關注的是用推理達到科學確定性,而辯證法和修辭則關注概率。后者適用于人類事務。

上面兩段文字我摘自網絡百科,雖無法確認其原文與出處(尤其是概率那部分),卻令人叫好。

然而,在隨后的年代里,亞里士多德的邏輯和確定性知識體系更大程度地影響了人類。

人們信奉因果論和決定論,在牛頓的推動下,世界仿佛是一個由無數個精密齒輪構成的機器,在上帝的首次推動下,持續有條不紊地運轉著。

而另外一條線索亦在孕育之中。休謨的懷疑論和經驗主義徹底改變了人們的思想世界,他認為感性知覺是認識的唯一對象,人不可能超出知覺去解決知覺的來源問題。

在休謨看來,客觀因果并不存在。????????

隨后康德試圖對理性主義和經驗主義進行調和,他否認客觀因果聯系,但主張用先天的理智范疇對雜亂的經驗進行整理。??

馬赫則開創了經驗批判主義,他強調直接討論觀測數據,科學定律只是被視為以最經濟的方式對數據進行描述的手段而已。

《科學推斷》一書認為,他開啟了現代方法論的主要進展。

曾經深受馬赫影響的愛因斯坦,無法接受這種對科學信仰的破壞性,以及對法則、公式、定律的輕視,后來與其分道揚鑣。

愛因斯坦用探索性的演繹法建構了邏輯嚴謹的原理,他相信宇宙有解,不相信鬼魅之力。

某種意義上,愛因斯坦是最后的牛頓(除了用斯賓諾莎的“神”替代了上帝),是科學因果決定論的捍衛者。??

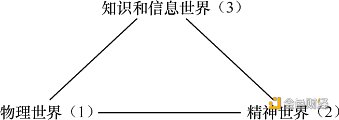

1967年,波普爾對如上交織而漫長的哲學歷程做了一個了結,他提出了三元世界的觀點,布爾金將其繪制如下:

這似乎是柏拉圖洞穴理論的現代版。

看看,人是多么無知,又是多么分裂啊!

基于這樣的結構,波普爾提出:我們無法證實這個世界,無法證實規律和定理,只能去證偽。

也許你還記得上一代的老實人工智能--深藍。龐大的機器,手工制作無盡的代碼,多名參與其中的職業棋手,以及暴力算法,雖然打敗了卡斯帕羅夫,卻如流星般閃過。

《麻省理工科技評論》將深藍形容為恐龍,而這一代的神經網絡(尤其是深度學習)則是生存且改變地球的小哺乳動物。

上世紀50年代,香農曾經樂觀地預測AI將很快出現,事實并非如此。失敗的主要原因是:

人工智能的創造者們試圖用純粹的邏輯來處理日常生活中的混亂,他們會耐心地為人工智能需要做的每一個決定都制定一條規則。但是,由于現實世界過于模糊和微妙,無法以刻板的方式進行管理。

跨鏈交易平臺Chainflip將向社區空投475萬枚FLIP:3月22日消息,跨鏈交易平臺Chainflip Labs已上線Token查詢頁面,將向社區空投475萬枚FLIP,用于分配給在2020/21年度參與服務節點空投計劃的服務節點運營商。

此前報道,Chainflip于2021年8月宣布完成600萬美元融資并于2022年5月宣布完成1000萬美元融資。[2023/3/22 13:18:04]

我們無法像是依照牛頓的原理造車般,用發條思維和專家系統來打造智能系統。那一類AI不僅狹窄,而且脆弱。

ChatGPT是經驗主義的進化論的“勝利產物”。

經驗主義亦稱“經驗論”。作為一種認識論學說,與“理性主義”相對。經驗主義認為感性經驗是知識的來源,一切知識都通過經驗而獲得,并在經驗中得到驗證。

這正是ChatGPT的思考和學習路徑。

而虛擬進化又指數級放大了基于經驗的學習速度。在波普爾看來,科學發展本身就是一種進化。

ChatGPT不僅從時間的角度加速模擬了進化,還通過大模型從空間的角度拓展了可能性之廣度,以至于令人們禁不住又驚又喜地探討起涌現。

那么,人工智能是如何思考的?又是如何決策的???

有別于齒輪般的演繹推理,我們需要借助概率在證據和結論之間建立起聯系。????

AI的任務是做決策,在不確定性下結合信念與愿望,選擇動作。

《人工智能:現代方法》如此描述:

由于部分可觀測性、非確定性和對抗者的存在,真實世界中的智能體需要處理不確定性(uncertainty)。智能體可能永遠都無法確切地知道它現在所處的狀態,也無法知道一系列動作之后結束的位置。

此外,智能體的正確的動作——理性決策,既依賴各種目標的相對重要性,也依賴它們實現的可能性和程度。

為了進行不確定推理,我們需要引入信念度,例如牙痛患者有80%的概率存在蛀牙。

???概率論提供了一種概括因我們的惰性與無知而產生的不確定性的方式。

除了概率,智能體在做決策時還需要一個概念:效用理論。?

例如,你要去機場,假如提前90分鐘出發,趕上飛機的概率是95%;提早120分鐘出發,概率提升至97%。??????

那么,是不是應該越早越高,追求趕上飛機的最大概率呢?如此一來,你可能要提前一天或者更早住在機場了。??????

大多數時候不必如此,但假如你有一個無法錯過的會議,或者要趕國際航班,提早一天住到機場,可能是最佳決策。萬豪酒店最早就是靠洞察到商務人士的這一需求而崛起的。????

由此,我們得出決策論的通用理論:??

決策論=概率論+效用理論

以上的現代方法,離不開兩個未曾謀面的古代敵手。

在諸多反對休謨的人當中,貝葉斯也許是最重要的一位。

當休謨斬斷了因果之間的必然聯系時,最惱火的莫過于教會,因為上帝一直被視為因果的第一推動力。??????

一個人往往要到了一定歲數,才能夠理解休謨的哲學。尤其是我們這些從小接受確定性訓練的人。

邏輯推理的基本形式是:如果A,則B。

休謨則說,如上這類推理要么是幻覺,要么是胡說八道,要么是自圓其說。

據說虔誠且又擅長數學的牧師貝葉斯是為了反駁休謨,而研究出了貝葉斯公式。???

一個神奇的結局出現了,貝葉斯公式反而成為了休謨哲學的現實解藥,將其大刀斬斷的因果,用逆概率的懸橋連接了起來。?????????

概率,將邏輯推理的形式修正為:如果A,則有x%的可能性導致B。??

而貝葉斯公式,則完成了一個小小的(卻產生了無法估量的巨大影響)由果推因的顛倒:

如果觀察到B,則有x%的可能性是因為A導致。

如此一來,被休謨懷疑的世界,繼續晃晃悠悠地構建出更為龐大繁復的、以概率關聯的因果網絡。??????????????

假如貝葉斯試圖反擊休謨的動機是真的,就為“要愛惜你的對手”添加了有力論據。???

讓我們用一個簡單的貝葉斯計算,來看看智能體如何學習經驗。????

題目:黑盒子里有兩個骰子,一個是正常骰子,扔出數字6的概率是1/6;一個是作弊骰子,扔出數字6的概率是1/2。????????

這時,你從中摸出一個骰子,扔了一次,得到一個6。??

請問:你再扔一次得到6的概率是多大?

計算的第一步,是計算這個骰子是正常骰子和作弊骰子的概率分別是多大。

請允許我跳過貝葉斯公式快速計算如下。????????

是正常骰子的概率為:1/6 ÷(1/6+1/2)=1/4??????

是作弊骰子的概率為:1/2 ÷(1/6+1/2)=3/4

計算的第二步,更新這個骰子的信息。原來的概率是各1/4,但現在分別是1/4和3/4。??

那么,再扔一次,得到6的概率就是:1/4×1/6+3/4×1/2=5/12。?

Cardano生態DEX MilkySwap與Multichain達成合作:3月26日消息,Cardano生態基于Milkomeda的DEX MilkySwap宣布與Multichain達成合作,此次合作將允許每個用戶將代幣橋接至Milkomeda,并在MilkySwap上交換或挖礦。[2022/3/27 14:19:47]

從本質層面理解如上這個簡單的計算并不是容易的事情:

兩次扔骰子都是獨立事件,為什么第一次扔骰子得到6的概率和第二次的概率不一樣?

貝葉斯概率的解釋是,第一次扔骰子得到6的這一結果,作為信息,更新了我們對第二次扔骰子得到6的概率的判斷。

疑惑的人會繼續問:骰子沒有記憶,為什么第一次的結果會“改變”第二次結果呢??

答案是:沒有改變結果,只是改變了“信念”。

即使扔了兩次骰子,我們依然不知道這個骰子是正常的還是作弊的,但我們可以帶著這種不確定性向前走,為此需要“猜”這個骰子是正常還是作弊的概率。這個概率,就是信念。???????

根據信息的變化,快速更新,體現了某種達爾文式的進化。????

從這個角度看,AI推理起初或許弱小含混,卻有主動適應性,從經驗中不斷學習,并快速演化。

以本題為例:第二次扔骰子,從第一次骰子的結果中學習了經驗,從而令預測更加精確。

這個過程還可以不斷重復,如同發動機般,從而產生了決策和智能的杠桿效應。

如前所述,亞里士多德曾經認為,修辭和概率等不確定性元素,應該應用于人類社會。而在自然科學和數學領域,則是邏輯推理(尤其是數學邏輯)的陣地。??

而如今,確定世界已經成為不確定世界,絕對真理也被或然真理替代。??

于是,概率不僅成為“真理”的懸梯,甚至成為真理本身。???

《人工智能:現代方法》寫道,世界就是這樣,實際示范有時比證明更有說服力。基于概率論的推斷系統的成功要比哲學論證更容易改變人的觀點。

就像兩個人就不同的觀點爭論,一種辦法是講道理,講邏輯;還有一種辦法是:?????

我們先下個注,然后試著跑跑看唄。??

在《人工通用智能的火花:GPT-4的早期實驗》的報告里,微軟實驗室如此表述:??

“我們過去幾年,人工智能研究中最顯著的突破是大型語言模型(LLMs)在自然語言處理方面取得的進展。

這些神經網絡模型基于Transformer架構,并在大規模的網絡文本數據體上進行訓練,其核心是使用一個自我監督的目標來預測部分句子中的下一個單詞。”

ChatGPT,是位“語言游戲”的高手,用的是神經網絡和深度學習。

這與傳統的語言,以及邏輯語言,都不一樣。

羅素曾經試圖構建一套邏輯語言,想從少數的邏輯公理中,推演出數學。

他提出了自己邏輯原子主義,試圖消除那些形而上語言的混亂,以邏輯語言和我們的現實世界一一對應。

在與羅素的相互影響下,維特根斯坦認為哲學的所有問題其實就是語言問題,從而推動了哲學的語言轉向。

一種西方哲學史觀點認為:古代哲學關注本體論,近代哲學關注認識論,20世紀哲學關注語言學問題。

那么,作為“系統地從語言來思考世界的第一人”,維特根斯坦與羅素有何不同?

陳嘉映的論斷是:羅素從本體論來思考語言的本質,維特根斯坦則一直從語言的本質來構想本體論。

也許我們能從羅素給情人奧托林·莫雷爾夫人一封信里,發現維特根斯坦哲學上的某些經驗主義線索:

“我們這位德國工程師啊,我認為他是個傻瓜。他認為沒有什么經驗性的東西是可知的——我讓他承認房間里沒有一頭犀牛,但他不肯。”

和每個天才一樣,維特根斯坦卓絕,但也疑惑。

再說回ChatGPT,它懂語言嗎?如同《天才與算法》一書的設問:

機器可以在不理解語言或不接觸周圍物理世界的情況下,生成有意義的句子,甚至是美的句子嗎?

老派的AI,試圖采用羅素的方法。這類模型認為:

“理性和智能是深度的、多步驟的推理,由一個串行過程指揮,并由一個或幾個線程組成,使用少量的信息,由少量的強相關變量來表達信息。”

對比而言,“現代的機器學習模式由淺(少步)推理組成,使用大量信息的大規模并行處理,并涉及大量弱相關變量。”

一個有趣的來描述二者對比的例子是,電影《模仿游戲》里的圖靈,炒掉了自己的密碼破解小組里的語言學專家。

《人工智能:現代方法》認為,純粹的數據驅動的模型,對比基于“文法、句法分析和語義解釋”的手工構建方法,更容易開發和維護,并且在標準的基準測試中得分更高。

該書作者還提及:

可能是Transformer及其相關模型學習到了潛在的表征,這些表征捕捉到與語法和語義信息相同的基本思想,也可能是在這些大規模模型中發生了完全不同的事情,但我們根本不知道。

未必那么精確的類比是:AI如孩子般學習語言。這正是當年圖靈所所設想的:有一個孩子般的大腦,然后去學習。而非一開始就設計一個成年人的大腦。????

UniFarm與Multichain合作進行跨鏈轉移:官方消息,UniFarm與Multichain達成合作,通過Multichain的跨鏈路由器協議實現跨鏈傳輸。[2022/2/9 9:40:30]

孩子不懂語法構建,也沒有成熟的邏輯,也遠沒有成年人那樣有主動的刻意練習。可是想想看,成年人學習語言的效率,與孩子對比,是不是爛到渣?

我不禁聯想起一個對教育的嘲諷:天生就是語言學習天才的孩子,卻要在一輩子都學不好一門語言的成年人的指導下學習語言。

讓我們來看看,AI如何像一個孩子般,天才般地學習。

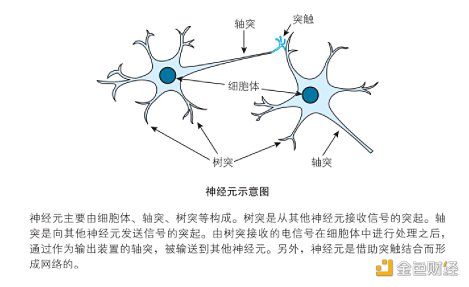

AI的神經網絡,是對人類大腦和基于社會化網絡的人類群體智慧的模仿游戲。

人類大腦神經元結構和工作原理如下:

圖片來自《深度學習的數學》一書。

以上原理,用計算模擬和解釋,就是:神經元在信號之和超過閾值時點火,不超過閾值時不點火。

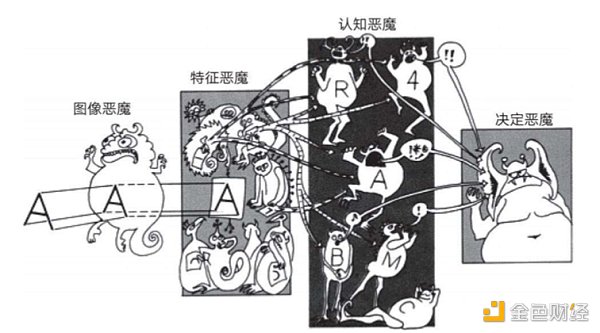

20世紀五六十年代,????奧利弗·塞弗里奇創造了名為“鬼域”的概念。這是一個圖案識別設備,其中進行特征檢測的“惡魔”通過互相競爭,來爭取代表圖像中對象的權利。

“鬼域”是生動的關于深度學習的隱喻,如下圖:??

圖片來自《深度學習》一書。

上圖是對當前多層次深度學習網絡的隱喻:

1、從左到右,是從低到高的惡魔級別。

2、如果每個級別的惡魔與前一個級別的輸入相匹配,就會興奮(點火)。?

3、高級別的惡魔負責從下一級的輸入中提取更復雜的特征和抽象概念,從而做出決定。然后傳遞給自己的上級。

4、最終,由大惡魔做出最終決定。

《深度學習的數學》一書中,依照如上隱喻,用一個生動的例子,講解了神經網絡的工作原理。

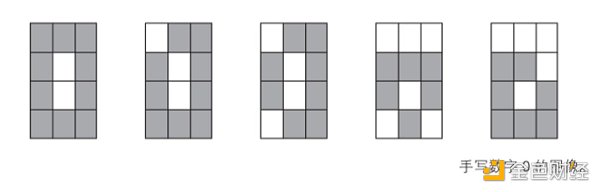

問題:建立一個神經網絡,用來識別通過 4×3 像素的圖像讀取的手寫數字 0 和 1。

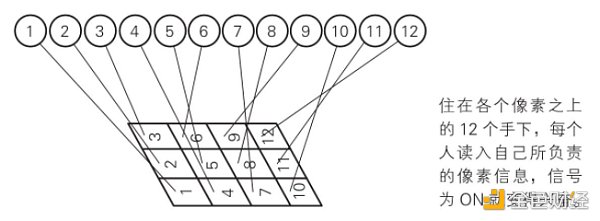

第一步:輸入層

12個格子,相當于每個格子住一個人,分別編號為1-12。如下圖。

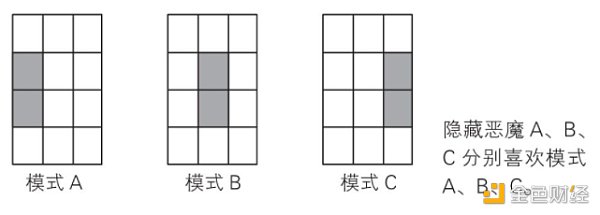

第二步:隱藏層

這一層,負責特征提取。假設有如下三種主要特征,分為為模式A、B、C。如下圖。??

不同的模式對應著相應的數字格子的組合。如下圖。模式A對應的是數字4和7,B對應5和8,C對應6和9。

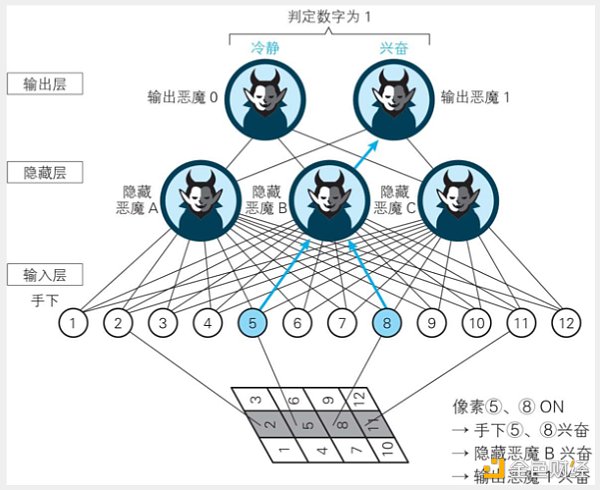

第三步:輸出層

這一層,從隱藏層那里獲得信息。

如上圖,最下面是AI要識別的圖像。

首先,輸入層的2、5、8、11點火;

然后,隱藏層5和8所對應的特征被提取,“模式B”點火;??

最后,輸出層的1被對應的“模式B”點火。?

所以,“大惡魔”識別出圖像為數字1。?

在上面的例子里,AI可以精確地識別出0和1,但它并不懂0和1,它的眼里只有像素。

可這么說,似乎過于擬人化了。人類又如何懂0和1呢?

人類不也是通過雙眼輸入,通過迄今仍是宇宙間最大謎團的大腦神經元網絡(更加復雜、強大且節能的隱藏層)提取特征,然后通過大腦的某個部位再進行自我解釋的嗎????????????????

辛頓曾在采訪中提及,認知科學領域兩個學派關于“大腦處理視覺圖像”的不同理念:?????

一派認為,當大腦處理視覺圖像時,你擁有的是一組正在移動的像素。如同上面的演示;

另一學派偏向于老派的人工智能,認為是分層、結構性的描述,腦內處理的是符號結構。

辛頓自己則認為以上兩派都不對,“實際上大腦內部是多個神經活動的大向量。”而符號只是存在于外部世界。

不管怎樣,神經網絡的模型有用,并且非常有用。?????

不愿意和外行分享專業話題的辛頓,用如下這段話生動介紹了“神經網絡”:

首先是相對簡單的處理元素,也就是松散的神經元模型。然后神經元會連接起來,每一個連接都有其權值,這種權值通過學習可以改變。

動態 | 谷歌云故障影響 Cosmos 驗證人 Polychain Labs 前夜暫時下線 現已恢復驗證:谷歌云前夜在美國東海岸發生大規模故障,影響了包括 Gmail、Snap、Discord 等互聯網服務,也影響了部分美國的 Cosmos 驗證人節點。Cosmos 的主要驗證人 Polychain Labs 昨夜發布消息,稱谷歌云故障影響該節點暫時離線,但是該團隊啟用備用服務,在一個小時左右恢復上線。Tendermint 研究負責人 Zaki Manian 表示,Cosmos Hub 在互聯網連接出現大故障時保持運行,表現不錯。[2019/6/3]

神經元要做的事就是將連接的活動量與權值相乘,然后累加,再決定是否發送結果。如果得到的數字足夠大,就會發送一個結果。如果數字是負的,就不會發送任何信息。

你要做的事就是將無數的活動與無數的權重聯系起來,然后搞清如何改變權重,那樣就行了。問題的關鍵就是如何改變權重。

神經網絡和深度學習經歷了并不算短暫的黑暗期。

從上世紀80年代開始的整整30年間,只有很少一部分相關研究者義無反顧地投身其間,他們飽受懷疑,也幾乎拿不到科研經費。????????????????

也許是由于這個原因,深度學習三巨頭辛頓(Hinton)、本吉奧(Bengio)、楊立昆(LeCun)似乎都和加拿大有些關系,他們退守在那里研究、教學、讀書。這倒是很符合那個“傻國家”的氣質。

一個讓人“心酸”的細節是,2012年辛頓帶著學生在 ImageNet 圖像識別比賽上拿了冠軍,商業公司蜂擁而至。辛頓教授開出的商業報價,只是區區一百萬美元。

(后來谷歌以4400萬美元“中標”。)

“老派”AI,使用明確的一步步指令指引計算機,而深度學習則使用學習算法從數據中提取輸入數據與期望輸出的關聯模式,正如上一節的演示。

眾所周知,漫漫長夜之后,隨著人類計算機算力和數據的指數級增長,深度學習一飛沖天,從阿爾法狗一戰封神,再到ChatGPT征服全球。????

為什么是Open AI,而不是DeepMInd?我對此略有好奇。

OpenAI的聯合創始人兼首席科學家伊利亞·薩特斯基弗,是辛頓在多倫多大學帶的學生。

他似乎延續了辛頓對深度學習的信仰,并且勇于全力下注。????

辛頓認為“深度學習足以復制人類所有的智力”,將無所不能,只要有更多概念上的突破。例如“transformers”利用向量來表示詞義的概念性突破。

此外,還要大幅度增加規模,包括神經網絡規模和數據規模。例如,人腦大約有100萬億個參數,是真正的巨大模型。而GPT-3有1750億個參數,約比大腦小一千倍。

神經網絡模仿了人類的優勢:處理有大量參數的少量數據。但人類在這方面做得更好,而且節能許多倍。

先行一步的DeepMInd,其發展方向和速度,除了陷入與谷歌的“商業VS科研”的兩難糾纏,還不可避免地受到哈薩比斯的AI哲學觀的影響。

哈薩比斯認為不管是ChatGPT,還是自家的Gopher,盡管可以幫你寫作,為你繪畫,“有一些令人印象深刻的模仿”,但AI“仍然不能真正理解它在說什么”。

所以,他說:“(這些)不是真正的意義上的(智能)。”

哈薩比斯的老師,MIT的Poggio教授更尖銳地指出:深度學習有點像這個時代的“煉金術”,但是需要從“煉金術”轉化為真正的化學。

楊立昆反對煉金術的提法,但他也認為要探究智能與學習的本質。人工神經元受到腦神經元的直接啟發,不能僅僅復制大自然。

他的觀點大概是,工程學實現了的東西,也只有通過科學打開黑盒子,才能走得更遠。??????????????

“我認為,我們必須探究智能和學習的基礎原理,不管這些原理是以生物學的形式還是以電子的形式存在。正如空氣動力學解釋了飛機、鳥類、蝙蝠和昆蟲的飛行原理,熱力學解釋了熱機和生化過程中的能量轉換一樣,智能理論也必須考慮到各種形式的智能。”

幾年前,巔峰時刻的哈薩比斯就表達過,僅靠神經網絡和強化學習,無法令人工智能走得更遠。

類似的反思,也發生于貝葉斯網絡之父 Judea Pearl。

他說,機器學習不過是在擬合數據和概率分布曲線。變量的內在因果關系不僅沒有被重視,反而被刻意忽略和簡化。

簡單來說,就是:重視相關,忽視因果。?????

在Pearl看來,如果要真正解決科學問題,甚至開發具有真正意義智能的機器,因果關系是必然要邁過的一道坎。????????

不少科學家有類似的觀點,認為應該給人工智能加上常識,加上因果推理的能力,加上了解世界事實的能力。所以,解決方案也許是“混合模式”--用神經網絡結合老式的手工編碼邏輯。?????????

辛頓對此頗為不屑,一方面他堅信神經網絡完全可以有推理能力,畢竟大腦就是類似的神經網絡。另一方面,他認為加入手工編碼的邏輯很蠢:

它會遇到所有專家系統的問題,那就是你永遠無法預測你想要給機器的所有常識。

AI真的需要那些人類概念嗎?阿爾法狗早已證明,所謂棋理和定式只是多余的夾層解釋而已。????????

關于AI是否真正“理解”,真正“懂得”,真正有“判斷力”,辛頓以“昆蟲識別花朵”為例:

“昆蟲可以看到紫外線,而人類不能,所以在人類看來一模一樣的兩朵花,在昆蟲眼中卻可能截然不同。那么能不能說昆蟲判斷錯誤了呢?昆蟲通過不同的紫外線信號識別出這是兩朵不同的花,顯然昆蟲沒有錯,只是人類看不到紫外線,所以不知道有區別而已。”

我們說AI“不懂”什么,會不會是過于以人類為中心了?

假如我們認為AI沒有可解釋性,算不上智能,可會不會是即使AI解釋了,我們也不懂?就像“人類只有借助機器檢測,看到兩朵花的顏色信號在電磁波譜上分屬不同區域,才能確信兩朵花確有不同。”

從十幾歲開始,就相信“模仿大腦神經網絡”的辛頓,仿佛有某種宗教式的堅定。

于是,在某個路口,哈薩比斯略有遲疑,而伊利亞·薩特斯基弗則和辛頓一路向前,豪賭到底。

辛頓的人生哲學是“基于信仰的差異化”,他的確也是如此實踐的。

如今,盡管哈薩比斯認為ChatGPT僅僅是更多的計算能力和數據的蠻力,但他也不得不承認,這是目前獲得最佳結果的有效方式。

對AI路線的分歧,不過是一百多年來某類科學暗涌的延續。

相當長的歲月里,在大雪紛飛的多倫多,辛頓幾乎是深度學習唯一的守夜人。

他本科在劍橋大學讀生理學和物理學,其間轉向哲學,拿的是心理學學士學位,后來再讀了人工智能博士學位。

辛頓等人在統計力學中得到靈感,于 1986 年提出的神經網絡結構玻爾茲曼機,向有隱藏單元的網絡引入了玻爾茲曼機器學習算法。

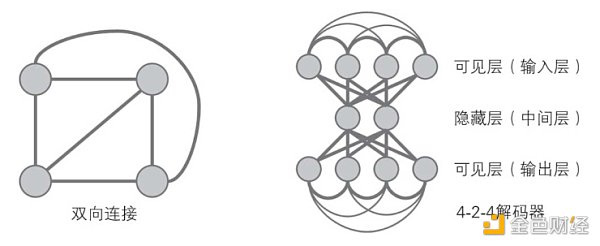

如下圖,所有節點之間的連線都是雙向的。所以玻爾茲曼機具有負反饋機制,節點向相鄰節點輸出的值會再次反饋到節點本身。

玻爾茲曼機在神經元狀態變化中引入了統計概率,網絡的平衡狀態服從玻爾茲曼分布,網絡運行機制基于模擬退火算法。

玻爾茲曼機。圖片來自《圖解人工智能》一書。

從香農,再到辛頓,他們都從玻爾茲曼那里獲得了巨大的靈感。

將“概率”引入物理學,看起來非常奇怪。??

人類直到19世紀之后,才知 道“熱”是物體內部大量分子的無規則運動的表現。那 么,為什么熱量總從熱的物體傳到冷的物體??????

玻爾茲曼說,原子(分子)完全是隨機運動的。并非是熱量無法從冷的物體傳到熱的物體,只是因為:?

從統計學的角度看,一個快速運動的熱物體的原子更有可能撞上一個冷物體的原子,傳遞給它一部分能量;而相反過程發生的概率則很小。在碰撞的過程中能量是守恒的,但當發生大量偶然碰撞時,能量傾向于平均分布。

這其中,沒有物理定律,只有統計概率。這看起來非常荒謬。??

堅定的科學主義者費曼,后來也提出“概率振幅”,用來描述物理世界的本質。

對此,費曼解釋道:這是不是意味著物理學——一門極精確的學科——已經退化到“只能 計算事件的概率,而不能精確地預言究竟將要發生什么”的地步了呢?是的!這是一個退卻!但事情本身就是這樣的:

自然界允許我們計算的只是概率,不過科學并沒就此垮臺。

也許是因為都持有“自下而上”的世界觀,玻爾茲曼喜歡達爾文,他在一次講座中宣稱:?????????

“如果你問我內心深處的信念,我們的世紀將被稱為鋼鐵世紀還是蒸汽或電的世紀呢?我會毫不猶豫地回答:它將被稱為機械自然觀的世紀,達爾文的世紀。”

對達爾文的自然選擇理論,玻爾茲曼認識到,生物之間通過資源競爭展開“一種使熵最小化的戰斗”,生命是通過捕獲盡可能多的可用能量來使熵降低的斗爭。

和生命系統一樣,人工智能也是能夠自動化實現“熵減”的系統。??

生命以“負熵”為食,人工智能系統則消耗算力和數據。?

楊立昆估算,需要10萬個GPU才能接近大腦的運算能力。一個GPU的功率約為250瓦,而人類大腦的功率大約僅為25瓦。

這意味著硅基智能的效率是碳基智能的一百萬分之一。

所以,辛頓相信克服人工智能局限性的關鍵,在于搭建“一個連接計算機科學和生物學的橋梁”。

達·芬奇曾說過:“簡單是終極的復雜。”

牛頓那一代相信上帝的科學家,認為神創造這個世界時,一定運用了規則。

他們只管去發現規則,而不必在意暫時的不可理解。例如,萬有引力公式為什么長成那樣?為什么要和距離的平方成反比?

另一方面,牛頓們信奉奧卡姆剃刀的原則,認為世界的模型基于某些簡潔的公式。他們至少相信存在某個這樣的公式,從愛因斯坦到霍金,莫不如是。

然而在不確定性時代,概率似乎比決定論派更能解釋這個世界。牛頓式的確定退縮到了有限的領域。

也許費曼是對的,科學家是在用一個篩網檢驗這個世界,某些時刻似乎所有的現象都能通過篩孔,但如今我們知道多么完備的科學都只是暫時的解釋,只是暫時未被證偽的篩網。但這并不影響我們向前。

還有一種哲學認為,世界本身就是在為自己建模。試圖用一個大一統理論解釋世界幾乎是不可能的,更何況宇宙還在繼續膨脹。

從以上有趣但略顯含混的角度看,ChatGPT是用一種反愛因斯坦的方式為世界建模。它有如下特點:

1、是概率的,而非因果的;

2、盡可能地去模擬人類世界這一“大模型”,從經驗中學習和進化,而非去探尋第一原理;

3、它信奉(至少暫時如此)“復雜是終極的簡單”;

4、它驅逐了神。因為它自己越來越像一個神。

AI和人類別的熱鬧事物一樣,經常會有周期性的熱潮。

上一波是2016年,熱起來,然后又慢慢靜下來。

七年過去了,AI再次熱起。Open AI照例沒有打開“黑盒子”,卻帶來了影響力更為廣泛的浪潮。

這一次,廣泛性似乎戰勝了專業性。人們似乎更關注那個會畫畫的、可能替代自己摸魚的AI,而不是那個能戰勝世界冠軍、能研究蛋白質折疊解決人類頂尖難題的AI。

這其中有多少是工程的突破和技術的飛躍?有多少是商業驅動下的大力出奇跡?有多少是人類社會慣常的泡沫?

毋庸置疑,人類過往的偉大突破,不少都是在多種理性和非理性力量的交織之下實現的。

這里面的機會是:

1、賣水者。如英偉達;

2、新平臺的出現;

3、新平臺既有通過生產力的提升創造的新價值空間,如各種全新的產品和服務,也有對舊有價值空間的掠奪;

4、AI會成為基礎設施。

但是,水和電成為基礎設施,互聯網成為基礎設施,與AI成為基礎設施,絕非簡單的類比或升級。

大概的趨勢也許是,商業上的壟斷與兩極分化會更加殘酷。職業上,或許中間階層會更加無望;

5、“場景”和“應用”會有機遇。尤其是那些能夠較好地利用AI平臺實現人機結合的場景與應用。

對個體而言,我們要問的是,AI還需要人類充當新基礎設施和新系統的類似于“操作員、司機、程序員、快遞員”的新時代角色嗎??????????????

哈耶克說:“一個秩序之所以可取,不是因為它讓其中的要素各就其位,而是在這個秩序上能夠生長出其他情況下不能生長出的新力量。”

迄今為止,我們尚不能定義什么是智能,什么是意識。??????

然而,卻有一個黑乎乎的盒子,告訴我們可能會超越人類的智能,甚至涌現出人類的意識。

微軟的報告中這樣寫道:

我們沒有解決為什么以及如何實現如此卓越的智能的基本問題。它是如何推理、計劃和創造的?

當它的核心只是簡單的算法組件--梯度下降和大規模變換器與極其大量的數據的結合時,它為什么會表現出如此普遍和靈活的智能?

AI研究人員承認,智能是否可以在沒有任何代理或內在動機的情況下實現,是一個重要的哲學問題。

在2023年的這個并不容易的春天,我對ChatGPT的態度坦然而期待:

我希望見到它所具備的可能性,為這個混亂的世界帶來某些“熵減”。??

在所有預測中,我期待Kurzweil的那個“2030 年技術將使人類享受永生”的預言。

我自己對永生沒興趣,但不想失去身邊的人們。我對世俗的依賴大過對“超人類主義”的擔憂。

我不太相信意識的上傳,因為一旦上傳,就可以復制,就不是唯一的,就失去了自由意志,又談何“意識”呢??

人類會洞察大腦最深層次的秘密嗎?湯姆·斯托帕警告過:

“當我們發現了所有的奧秘,并失去了所有的意義時,我們將會在空蕩蕩的海邊孤身一人。”

哥德爾的“不完備性定理”告訴我們,不確定性是人類認識的形式邏輯思維本身所固有的。

“一個計算機可以修改自身的程序,但不能違背自身的指令——充其量只能通過服從自身的指令來改變自身的某些部分。”

哥德爾算是為AI,為人類劃定了邊界嗎?否則,人類制造超級AI,然后拜其為神,何嘗不是自我奴役??

哥德爾又告訴我們,人類永遠可以在“實在主義”中通過“直觀和直覺”引入構成高一級形式系統的新東西,建立新公理系統,如此推進以至無窮。

這就是彭羅斯所持的那種“人心超過計算機”的觀念。

上一次,七年前,在阿爾法狗面前,人類曾經哭泣過;

這一次,無人哭泣,卻有萬眾狂歡。

在兩次AI高潮之間的7年里,我們經歷了許多,失去了許多。

人們渴望擁抱某些希望,某些確定性,即使那些確定性來自一些不確定性的智慧。????

就我自己而言,也遭遇了一些前所未有的艱難時刻。所謂艱難,并非指一些困難的抉擇,也并非說沒有選項。???????

恰恰相反,依照最優決策原理,我很容易通過期望值計算,得出最佳選項,獲得所謂最大化的收益。

然而,我追溯到內心的源頭,重新定義了自己的期望效用,然后據此做出了有點兒辛頓風格的“基于信仰的差異化”選擇。??????

對任何一個人而言,不管是難是易,是聰明是愚蠢,是理性是任性,這種事兒在技術層面都只算小菜一碟。

可對AI來說,自己去定義期望效用,暫時難于登天。??

所以,研究人員稱,為“大型語言模型”配備代理權和內在動機是未來工作的一個迷人的重要方向。

而“代理權”與“內在動機”這兩點,一個普通人類只需要一秒鐘或者幾個不眠之夜即可實現。??

或許關鍵不在于得失,不在于效用函數,而在于“存在”。

如伊塔洛·卡爾維諾所言:

“隨著時光流逝,我慢慢地明白了,只有存在的東西才會消失,不管是城市,愛情,還是父母。”

大概是人類自作多情吧,在斯皮爾伯格的電影《A.I.》里,機器舞男被抓去銷毀前,最后對小男孩深情地說:

“I am,I was!”

“我存在,我曾經存在!”

36氪

媒體專欄

閱讀更多

金色財經 善歐巴

金色早8點

白話區塊鏈

歐科云鏈

Odaily星球日報

Arcane Labs

MarsBit

深潮TechFlow

BTCStudy

鏈得得

原文:EigenLayer Restaking Explainer 作者:林瑋宸Albert Lin隨著Ethereum 上海升級時間點越來越接近.

1900/1/1 0:00:00原文作者:Mary Liu,比推 BitpushNews 當地時間 4 月 18 日,美國證券交易委員會(SEC)主席 Gary Gensler 出席眾議院金融服務委員會聽證會.

1900/1/1 0:00:00金色財經記者 Jessy近日, 社區內正在為一項為新成立的去中心化自治組織 (DAO) 引入管理機構的提案—— Arbitrum 改進提案 1 (AIP-1)引發了熱議,4月4日.

1900/1/1 0:00:00撰寫:ZERO IKA 編譯:深潮 TechFlow現實世界資產代幣化正成為一個備受關注的領域。通過將實物轉化為數字代幣,現實世界資產可以在區塊鏈上變得可交易、可分割,并為更多人所持有.

1900/1/1 0:00:002023 年開年,Layer 2 熱度在久經準備后居高不下,已有人將 2023 年稱為“Layer 2 ”之年.

1900/1/1 0:00:00萬眾矚目的“2023數字經濟峰會”于4月14日在香港會展中心圓滿結束。“2023數字經濟峰會”堪稱是亞洲的創新科技旗艦盛事,由香港特別行政區政府及數碼港聯合舉辦,匯聚科技、政商及學術領袖.

1900/1/1 0:00:00